Et mes fesses, elles sont roses, mes fesses ?

19 juin, 2016

C’est très compliqué, d’expliquer pourquoi dépister un cancer ne sauve pas forcément de vies, et pourquoi ne pas dépister peut parfois le faire.

D’abord parce que c’est tout à fait contre intuitif.

C’est facile, joli et surtout rassurant de se dire « On passe un examen pour chercher un cancer, pis si on en trouve un on peut le traiter avant qu’il ne soit trop tard. » C’est super séduisant, ça paraît absolument logique. Alors qu’expliquer le contraire, c’est relou, ça demande des maths et des stats et des raisonnements chiants. Et puis on n’a pas très envie d’y croire, même quand on a tout lu avec les sourcils froncés et tout compris. On a vite envie de revenir à la logique intuitive, de dire « Oui ok c’est bien beau tout ça mais c’est rien que des stats, et moi je ne suis pas une stat. »

Ensuite parce que c’est la seule partie visible de l’iceberg.

On connait tous, de près ou de loin, quelqu’un qui a été sauvé par le dépistage d’un cancer.

On a tous un exemple pour dire « Oui bah peut-être mais en attendant, si ma tante avait pas passé de mammographie, on aurait jamais trouvé son cancer et maintenant elle va très bien et elle est très reconnaissante qu’on lui ait sauvé la vie » ou malheureusement pour dire « Oui bah peut-être mais en attendant, ma tante s’est pas fait dépister et elle a eu un cancer et elle est morte. »

Et ça fausse la vision.

Parce que précisément on ne peut voir que ça : on ne peut voir que ce qui se passe, et on ne peut pas voir ce qui ne se passe pas. Du coup, aucun patient ne viendra jamais me dire « Ohlala docteur merci tellement de ne pas m’avoir dépisté quand j’avais 60ans, je ne serais plus là pour vous remercier si vous l’aviez fait », parce qu’on ne peut pas savoir.

Et ça renforce encore cette impression intuitive que le dépistage, ça doit forcément marcher : c’est absolument logique que ça marche ET on a des exemples sous les yeux de gens pour qui tout porte à croire que ça a marché.

Et pourtant, en médecine, on essaie de baser nos attitudes sur des faits, sur des études.

Avant de donner un médicament, on essaie de prouver qu’il est efficace, et qu’il apporte le plus souvent plus de bien que de mal quand on le prescrit. (Bon, on foire souvent, hein. Mais dans l’idée, on est censés essayer de le faire.)

C’est la « balance bénéfice-risque ». On essaie de fonctionner comme ça le plus souvent possible, parce que précisément les « Moi j’ai l’impression que ça marche sur mes patients » et les « Ca semblerait logique que ça marche donc ça devrait marcher », bin c’est pas suffisant.

Et hélas, on a de plus en plus de grosses études, avec des gros effectifs et des longues années de recul qui viennent nous mettre sous le nez les unes après les autres ce résultat dérangeant : la plupart de nos stratégies de dépistages précoces des cancers ne sauvent pas de vie.

Et croyez le bien, ça ne me réjouit pas plus que vous.

Du coup, avec mon ami physicien-qu’est-plus-balaise-que-moi-en-pubmed-et-en-lectures-critiques-d’articles, on va essayer de se fader un billet long et chiant pour essayer d’expliquer un peu tout ça, et où on en est aujourd’hui de ce qui a l’air de sauver des vies ou pas.

Parce que face aux Octobres Roses, aux Novembres Marron et autres campagnes médiatiques qui coûtent un bras (souvent intéressé, le bras…) et s’immiscent chez vous par la télé et les journaux en sortant les violons et en jouant sur votre peur, plus on est nombreux à essayer de faire entendre les voix de la raison opposées, mieux c’est.

(Vous trouverez en bas d’article tout un tas d’autres références d’autres articles sur d’autres blogs qui traitent du même sujet.)

A/ INTRODUCTION

D’abord, on va commencer par schématiser le processus de dépistage, tel qu’il est pratiqué la plupart du temps. L’idée est la suivante :

Vous passez un examen peu invasif (c’est-à-dire peu dangereux, qui ne fait pas trop mal, qui n’a pas trop de risques de complications) et si possible un minimum fiable.

Cet examen ne cherche pas le cancer directement, mais un signe dont on sait qu’il est souvent lié au cancer. (une image moche à la mammographie, une anomalie sur une prise de sang, du sang dans les selles).

Si cet examen revient positif, c’est-à-dire s’il trouve une anomalie, on se dit qu’il y a peut-être un cancer, et on passe à un examen plus performant mais souvent plus invasif (une biopsie, une coloscopie).

Si ce deuxième examen revient lui aussi positif, on pose le diagnostic de cancer et on vous propose un traitement.

Encore une fois, ça paraît beau et logique.

Le souci, c’est qu’aucun des maillons de cette chaîne n’est infaillible, et que les erreurs mises bout à bout peuvent aboutir des trucs pas sympas, qui viennent tout encafouiller notre jolie logique instinctive.

Les failles sont les suivantes :

1/ Les examens préliminaires peuvent se tromper (souvent) et occasionner des complications (rarement).

2/ Les examens de confirmation peuvent se tromper (plus rarement) et occasionner des complications (plus souvent).

3/ Certains cancers peuvent guérir tout seul ou évoluer tellement lentement qu’on mourra d’autre chose avant qu’ils ne se manifestent.

4/ Les traitements proposés pour les cancers peuvent occasionner des complications (très souvent), qui peuvent être graves (souvent) voire mortelles (rarement).

5/ Nos outils pour mesurer l’impact et le bénéfice d’un dépistage sont bourrés de failles eux-aussi.

Dans la première partie, je vais juste poser le raisonnement. Avec des chiffres inventés et faux, juste pour l’illustration. Les vrais chiffres viendront dans la deuxième partie…

1/ Les examens préliminaires peuvent se tromper.

On va entamer gaiement avec un peu de stats. Ça s’appelle le théorème de Bayes, et je vous jure que c’est plus rigolo que ce la formule en donne l’impression :

Oui hein ? Promis.

Bon. Prenons un examen médical. Un examen de dépistage, tiens, au hasard. Qui doit répondre par Oui ou par Non à la question « Y a-t-il un signe de cancer ? ».

Vous le savez, aucun examen n’est fiable à 100%. Il peut toujours y avoir des ratés, même pour les examens très performants. Ce raté peut prendre deux formes :

– vous avez une anomalie et pourtant l’examen ne trouve rien et revient négatif : c’est ce qu’on appelle un « faux négatif »

– vous n’avez rien et pourtant l’examen trouve quelque chose et revient positif : c’est un « faux positif ».

La probabilité qu’a l’examen de bien trouver l’anomalie s’il y en a une s’appelle la sensibilité.

La probabilité qu’a l’examen d’être normal quand il n’y a pas d’anomalie s’appelle la spécificité.

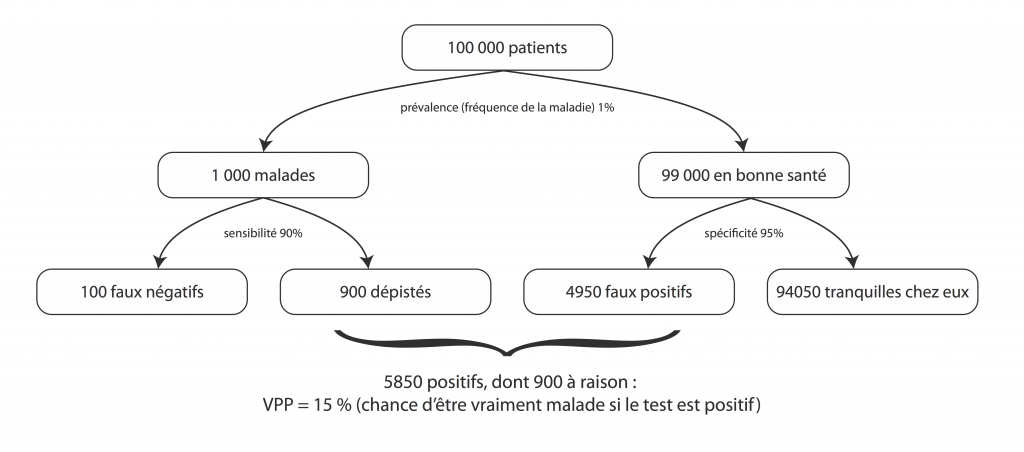

Prenons un test super performant, avec 90% de sensibilité (= si on fait passer le test à 100 personnes malades, il aura raison et trouvera une anomalie pour 90 d’entre elles) et 95% de spécificité (= le test aura raison et sera négatif chez 95% des personnes non malades).

Ces critères de sensibilité et de spécificité répondent à la question : « Si je suis malade, est ce que le test le voit ? », autrement dit « Est-ce que ce test est balaise ou pas ? ».

Mais la vraie question qui nous intéresse, en pratique, en tant que patient et en tant que médecin, c’est pas « Si je suis malade, est ce que le test le voit ? » puisqu’on ne le sait pas, si vous êtes malades, justement. (Si on le savait on serait pas là à vous emmerder à passer des examens. Ce qu’on veut savoir, c’est pas si le test est balaise, c’est si vous êtes malade.)

La vraie question qui nous intéresse va dans l’autre sens, c’est : « Si le test dit que je suis malade, est-ce qu’il a raison ? ». Et ce n’est pas du tout la même question.

La probabilité que vous ayez vraiment une anomalie si le test dit qu’il y en a une, ça s’appelle la valeur prédictive positive. (VPP pour les intimes).

La probabilité que vous n’ayez pas d’anomalie si le test dit que tout va bien, ça s’appelle la valeur prédictive négative (VPN).

Intuitivement, on a tendance à confondre les deux questions et les deux réponses.

Si on dit « Le test a 90% de chances d’être positif si vous êtes malade », on a tendance à croire que « si le test est positif, c’est qu’on a 90% de risque d’être malade », et bin (roulements de tambours) figurez-vous que non dites donc ! Et loin, loin, loin s’en faut.

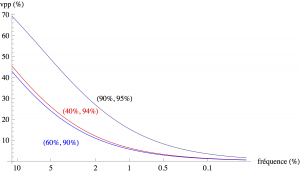

Parce que la VPN et la VPP ne dépendent pas que de la balaisité du test. Elles dépendent aussi fortement de votre probabilité AU DÉPART d’avoir la maladie, c’est à dire qu’elles dépendent aussi de la fréquence de la maladie et de vos propres facteurs de risques. Plus la maladie est rare, plus la probabilité au départ que vous soyez malade est faible, moins le test sera performant.

Et comme une bonne illustration vaut un bon steak, voyons ça ensemble.

Reprenons notre test super balaise de tout à l’heure. 90% de sensibilité, 95% de spécificité.

Prenons une maladie assez fréquente, qui touche une personne sur 100.

Faisons passer le test à 100 000 personnes.

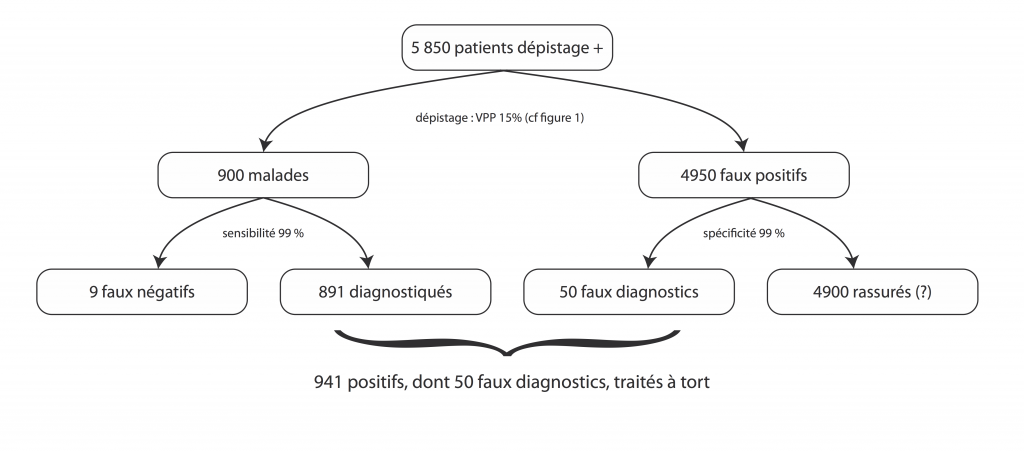

Voilà. Sur les 5850 personnes inquiétées par un test positif, 4950 sont saines.

Si votre test revient positif, vous n’avez que 15% de risque d’être malade (et donc 85% de risque d’avoir été inquiété à tort).

Pour un test excellent et une maladie pas si rare que ça.

Plus la maladie est rare, plus la VPP devient pourrie. Par exemple, pour une maladie qui touche une personne sur 1000, toujours avec le même test (90% de sensibilité, 95% de spécificité), elle chute à 1,8%.

Et ça, c’est juste pour une fois. Passez le test tous les deux ans pendant 10 ans, votre probabilité d’être un jour inquiété à tort passe grosso modo à 95%.

2/ Les examens de confirmation peuvent se tromper et ou causer des complications

a) Parce que oui, même une biopsie peut se tromper. Rien n’est fiable à 100%, jamais.

Je vous renvoie à cet article de Dominique Dupagne sur le sujet.

Une biopsie, grosso modo et de façon imagée, ça revient à mettre des cellules au microscope, et demander à un gars si elles sont jaunes (saines) ou rouges (cancéreuses). Même si le type au microscope est très fort, il y aura toujours des cellules orange / orange foncé pour lesquelles il sera difficile de trancher: la sensibilité et la spécificité d’une biopsie, même si elles sont très bonnes, ne sont pas à 100%, voilà, bravo, vous avez tout compris.

Juste pour s’amuser, reprenons les 5900 personnes de tout à l’heure, parmi lesquels, souvenez-vous, seulement 900 sont malades. Admettons pour être super larges que la sensibilité et la spécificité sont de 99% pour l’examen au microscope de leurs biopsies (et arrondissons un tout petit peu les calculs de trois fois rien parce que sinon ça devient illisible)

On obtient donc au final : 891 types qu’on va diagnostiquer à raison et à qui on va proposer un traitement, 4900 types qui repartiront chez eux rassurés (pour l’instant, parce qu’on risque parfois de leur reproposer de faire des biopsies régulièrement, pour surveiller, et de remettre le couvert une fois par an), au prix de 9 types qu’on va rassurer à tort alors qu’ils ont un cancer et 50 types à qui on va annoncer un faux diagnostic de cancer, et traiter à tort.

On obtient donc au final : 891 types qu’on va diagnostiquer à raison et à qui on va proposer un traitement, 4900 types qui repartiront chez eux rassurés (pour l’instant, parce qu’on risque parfois de leur reproposer de faire des biopsies régulièrement, pour surveiller, et de remettre le couvert une fois par an), au prix de 9 types qu’on va rassurer à tort alors qu’ils ont un cancer et 50 types à qui on va annoncer un faux diagnostic de cancer, et traiter à tort.

b) Ajoutons à ça que, par exemple, les coloscopies peuvent donner des perforations ou des infections, que l’irradiation de la mammographie augmente possiblement un tout petit peu le risque de cancer (et oui, c’est balot), que les biopsies de prostate peuvent entraîner des hémorragies ou des infections sévères, que l’anesthésie générale qui va avec présente elle-même des risques, y compris de décès…

Imaginons au final que l’examen entraîne une complication deux fois sur cent, et une complication mortelle une fois sur dix mille.

Sur les 5850 personnes de tout à l’heure, ça tourne quand même autour de 117 complications et un gros demi-mort. Alors qu’on n’a même pas encore commencé le traitement.

Au final, pour 100 000 types testés, dont 1000 malades, on aura :

5850 patients inquiétés, 891 diagnostiqués à raison, 109 rassurés à tort qui ont un cancer et qui ne le savent pas (les 100 faux négatifs de la première étape + les 9 de la deuxième), 50 diagnostiqués à tort qui vont avoir un traitement pour rien, et, répartis au hasard parmi les gens malades et les gens pas malades : 117 personnes qui auront une complication quelconque, et un demi-mort qui n’avait rien demandé à personne et qui serait en train de jardiner tranquillement si on lui avait foutu la paix.

Toujours, je le rappelle, pour un test de dépistage inventé pour les besoins de la démonstration et très performant.

3/ Certains cancers peuvent guérir tout seuls ou ne jamais évoluer.

C’est encore un truc difficile à admettre, mais cellule cancéreuse ne veut pas dire cancer.

Il est super fréquent d’avoir quelques cellules cancéreuses qui se baladent par ci par là, notamment pour la prostate chez les hommes âgés et dans le sein chez les femmes, même jeunes.

Plus on est performant pour trouver une petite cellule cancéreuse perdue, plus on la cherche, plus on a de chances de la trouver et moins on a de chances qu’elle ait été partie pour évoluer en vrai cancer méchant. Nous vous donnerons quelques chiffres plus bas, c’est vraiment beaucoup plus fréquent que ce qu’on croit.

Ou alors, les cellules cancéreuses peuvent former un vrai cancer, mais qui va rester sage tellement longtemps que la mort surviendra pour autre chose avant que le cancer ait eu le temps de se manifester. C’est très très très fréquent aussi.

Le souci, c’est que nos examens ne font pas la différence entre tout ça, et n’ont pas la boule de cristal pour savoir quels cancers vont évoluer ou pas.

Quand on pose un diagnostic de cancer dans une situation où le cancer ne serait pas devenu symptomatique, ou aurait régressé tout seul, ou tout simplement par erreur, on appelle ça un surdiagnostic.

Si on part sur un cancer sur deux qui aurait disparu ou n’aurait pas posé de souci, et qu’on reprend nos gus de tout à l’heure en arrondissant, on a 446 types à qui on a diagnostiqué un méchant cancer qui aurait posé problème et à qui on va peut-être rendre service, 9 rassurés à tort, 495 types surdiagnostiqués prochainement surtraités à qui on va faire courir des risques pour rien (50 chez qui on s’est trompé, + 445 chez qui le cancer n’aurait jamais évolué), et un demi-mort qui aimerait bien qu’on lui foute la paix, maintenant.

ALORS QU’ON A MÊME PAS COMMENCÉ LE TRAITEMENT !

4/ Les traitements du cancer, c’est pas marrant-marrant.

Je vais passer rapidement là-dessus, hein. Vous avez tous malheureusement un exemple d’un proche en tête. Les conséquences au niveau médical, mais aussi psychologique et social d’une chimiothérapie par exemple, je vais pas faire vibrer les violons : je pense que vous voyez.

Il y a parfois des morts, aussi, à cause des traitements. C’est pas si souvent, mais ça arrive. La iatrogénie que ça s’appelle.

L’idée, c’est que si on applique ces traitements à de gens qui en ont tous besoin, le jeu peut en valoir la chandelle (et encore, pas tout le temps mais c’est un autre débat).

Si on vous sauve la vie à coup sûr, ça peut valoir 20% de risques d’avoir une incontinence à vie ou un sein en moins. Ça peut même valoir le coup de mourir du traitement, puisque hey, on était parti pour mourir de toute façon.

Si on vous allonge votre espérance de vie de 5 ans contre 10 ans d’incontinence, déjà peut-être un peu moins, question de point de vue.

Mais si on traite 446 personnes qui ont besoin du traitement et 495 qui n’en auraient pas eu besoin, et qu’on a déjà tué un demi-mec en chemin rien que pour le diagnostic, tout de suite, c’est plus du tout la même chose. Surtout si on met dans la balance les morts-du-traitement qui sont dans le groupe des gens-qui-n’auraient-pas-eu-besoin-du-traitement.

5/ Nos outils pour mesurer l’impact bénéfiques d’un dépistage sont bourrés de failles eux-aussi

Pour mesurer l’impact du dépistage, pour savoir si on a bien sauvé des vies, on a plein de problèmes de partout. On a plein d’études biaisées qui disent par exemple que « l’espérance de vie après diagnostic d’un cancer de tel organe augmente », mais qu’il faut savoir décrypter. Voici quelques exemples de biais et d’incertitudes :

– Le type qui n’aurait pas besoin du traitement mais qui l’a eu quand même, lui, forcément, il va vivre longtemps. Vu qu’il était pas malade. (Y a rien qui guérit mieux qu’un cancer qui n’existe pas.)

Il va être compté dans les gens à qui on a sauvé la vie, par ses proches déjà (cf le tout début du texte et votre tante), mais aussi par les statistiques.

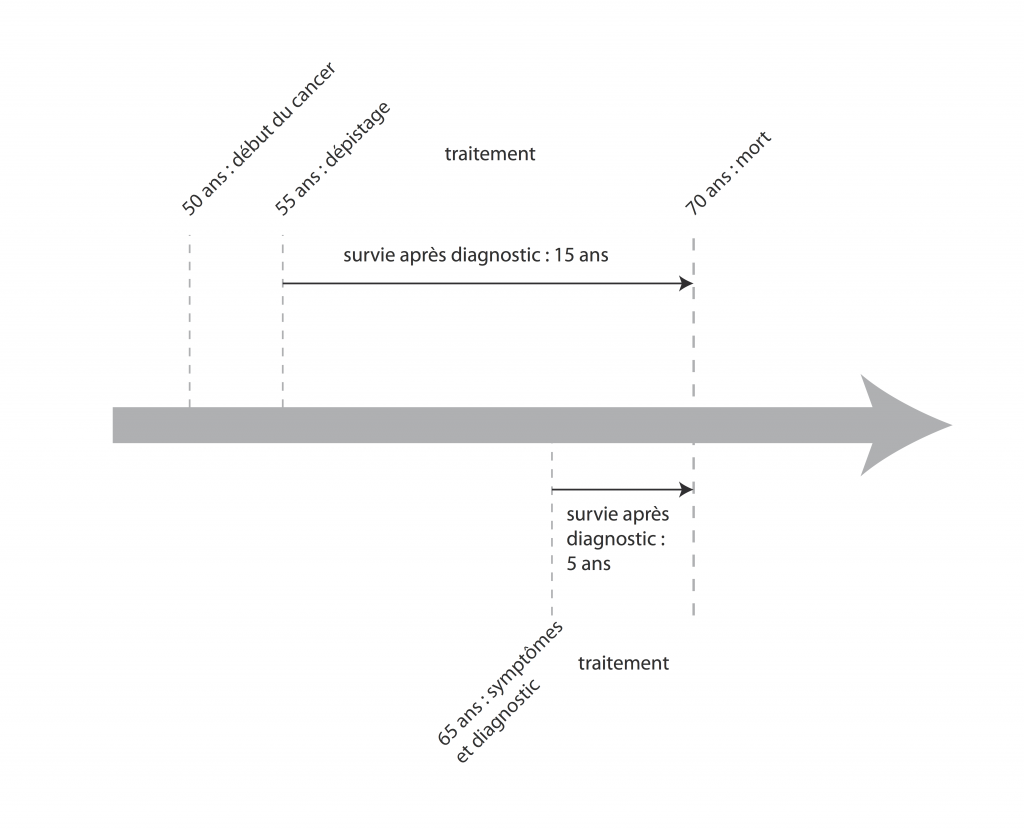

– Si on vous trouve un cancer à 55 ans parce qu’on l’a dépisté, et que vous en mourrez à 70, vous avez eu 15 ans d’espérance de vie.

Si on vous trouve un cancer à 65 ans parce que vous avez présenté des symptômes qui ont amené au diagnostic et que vous mourrez à 70ans, vous avez eu 5 ans d’espérance de vie.

C’est le même cancer, vous êtes mort au même âge, vous avez peut-être vécu angoissé et avec les effets indésirables de votre traitement dix ans de plus, mais pour les stats, c’est une vraie victoire : 3 fois plus d’espérance de vie grâce au dépistage !

– Des études comparent parfois les options « traitement ou non après un diagnostic de cancer », pour montrer que le traitement sert à quelque chose, mais cette comparaison n’a pas de sens. On ne vit pas de la même façon, ne serait-ce que psychologiquement, après avoir été étiqueté « cancéreux ». Pour réfléchir à l’intérêt du dépistage, il faudrait comparer [(dépistage + traitement) ou (dépistage + rien)] versus (pas de dépistage du tout)

– Des études comparent parfois les options « traitement ou non après un diagnostic de cancer », pour montrer que le traitement sert à quelque chose, mais cette comparaison n’a pas de sens. On ne vit pas de la même façon, ne serait-ce que psychologiquement, après avoir été étiqueté « cancéreux ». Pour réfléchir à l’intérêt du dépistage, il faudrait comparer [(dépistage + traitement) ou (dépistage + rien)] versus (pas de dépistage du tout)

– Des études à trop long terme peuvent attribuer au dépistage une augmentation de l’espérance de vie qui est en fait lié à d’autres choses (amélioration des traitements, par exemple).

– Bref, ce ne sont que des exemples (grossiers et partiels) mais au final : c’est compliqué d’évaluer sans biais l’efficacité d’une stratégie de santé publique. La seule chose qui doit nous intéresser, dans une étude, pour savoir si on sauve des vies ou pas, c’est la mortalité GLOBALE. La seule vraie façon de savoir, c’est de prendre 100 000 personnes à qui on fait passer le dépistage, 100 000 personnes à qui on ne le fait pas, et de regarder le nombre de mort à la fin EN TOUT. Comparer la mortalité spécifique, c’est à dire les morts « par cancer du sein » par exemple n’a pas de sens, parce que les sauvées du cancer du sein peuvent être compensées par celles qui sont mortes d’autres choses mais d’une façon ou d’une autre à cause du dépistage (effet iatrogène des médicaments, complications en chaîne, suicides parfois etc.).

6/ Du coup, au final :

– On aimerait bien pouvoir proposer aux gens d’être de bons médecins et de leur sauver vachement la vie, mais la réalité nous met des bâtons dans les roues.

– Beaucoup de dépistages actuellement proposés n’ont pas fait leur preuve de leur efficacité, et les preuves de leur nocivité ou de leur inefficacité sont de plus en plus probantes, hélas.

– C’est très difficile à croire, à voir et à expliquer.

– J’attire votre attention sur le fait que les examens qu’on va remettre en cause plus bas ne sont pas remis en cause en tant que tels. C’est leur utilisation dans un contexte de dépistage de masse, appliqué à toute la population sans distinction qui est remise en cause. Leur utilisation ponctuelle peut être tout à fait justifiée, en fonction des situations.

On a vu plus haut que le risque d’erreur dépend énormément de la probabilité au départ d’avoir une pathologie. Donc ce n’est pas du tout la même chose de faire une mammographie diagnostique à quelqu’un qui a senti une boule cheloue dans son sein ou une mammographie de dépistage a une femme qui a une mutation génétique augmentant le risque de cancer du sein que de faire des mammographies de dépistage systématique à toutes les femmes de 40ans. (-> le risque de cancer est plus important au départ -> la performance de l’examen devient meilleure)

B/ LES DIFFÉRENTS DÉPISTAGES EN L’ÉTAT ACTUEL DES CHOSES

Tous les dépistages conduisent à faux positifs et négatifs, surdiagnostics, surtraitements et effets indésirables. Un dépistage peut être clairement nuisible, inutile, ou utile, selon sa capacité à détecter les cancers qui justifient un traitement, l’ampleur des effets indésirables des examens et des traitement, et son impact sur la mortalité globale et la qualité de vie.

Lorsqu’un dépistage est statistiquement nocif, un médecin qui le propose systématiquement nuit, en moyenne, à ses patients.

Nous allons examiner les principaux exemples, cancers de la prostate, du sein, colorectal, et du col de l’utérus. L’objectif ici est d’essayer de s’abstraire de la charge émotionnelle liée au cancer pour se concentrer sur les faits.

1/ Le cancer de la prostate :

Le dépistage repose sur une prise de sang : le dosage d’une protéine produite par la prostate, le PSA, dont le taux augmente en cas de cancer, mais aussi avec des maladies bénignes comme les prostatites, et même naturellement avec l’âge à mesure que la prostate grossit.

Le dépistage est confirmé par une biopsie (effets indésirables : hématurie 16 %, prostatite aiguë 1 %, septicémie 0,5-2 %, trouver que se faire enfoncer une aiguille via l’anus à travers la paroi du rectum est pas super cool 99%).

Les biopsies confirment le cancer dans 10-20 % des cas, les autres sont des faux positifs du dosage du PSA.

Parmi ces 10 à 20% de biopsies positives, de nombreux cas sont en fait simplement des cellules cancéreuses isolées qui n’auraient jamais provoqué de cancer : plus de la moitié des hommes de 60 ans ont des cellules cancéreuses dans leur prostate, c’est un phénomène quasi normal et c’est le cas de près de 100% des hommes de 90 ans : des études sur des autopsies chez des hommes décédés pour d’autres causes (Sakr et al. 1994) trouvent des cancers histologiques chez 24 % des hommes, et par tranche d’âge respectivement 2 %, 29 %, 32 %, 55 %, et 64 % chez les hommes de 20-29, 30-39, 40-49, 50-59 et 60-69 ans. Ça veut dire que si on va fouiller la prostate d’une personne de 65ans morte d’autre chose, on a 64% de chance d’y découvrir des cellules cancéreuses.

Évidemment, puisque non, 64% des hommes ne meurent pas de cancer de la prostate, ça veut dire qu’une majorité de ces « cancers » seraient restés silencieux.

Ce réservoir très important d’hommes porteurs de cellules-cancéreuses-qui-ne-deviendront-pas-des-cancers amène à penser que, si on essaie seulement d’ « améliorer » le dépistage en trouvant de plus en plus efficacement des cellules cancéreuses, sans repenser les choses en profondeur, on aboutira seulement à un nombre ahurissant de surdiagnostics.

Les deux études les plus complètes sur l’impact du dépistage et du traitement sont Schroder et al. 2012 et Andriole et al 2012. Elles montrent un impact faible ou nul sur la mortalité spécifique (réduction absolue du risque spécifique de 0.071 % dans l’étude européenne), et nul sur la mortalité globale. Elles montrent un taux de surdiagnostic de l’ordre de 50 %, avec des effets secondaires de la chirurgie importants (incontinence, impuissance…).

Un bilan du surdiagnostic peut être trouvé dans Sandhu et al. 2012 et Loeb et al. 2014, et confirme sa très forte présence.

De tous les dépistages, celui du cancer de la prostate est l’exemple le plus clair de dépistage nocif : l’impact sur la mortalité est faible ou nul, l’impact sur la qualité de vie très négatif. Les taux de faux positif, de surdiagnostic, de surtraitement sont tous élevés. Effectuer un dosage de PSA sur un patient sans facteur de risque particulier est nuisible. Plusieurs pays recommandent officiellement de ne plus faire le dépistage systématique. En France la HAS (haute autorité de santé) ne le conseille plus (enfin !), même si de nombreux médecins continuent de le pratiquer.

2/Le cancer du sein

Le dépistage est effectué en général par mammographies, tous les ans ou tous les deux ans, à partir de 40, 45 ou 50 ans selon les recommandations, diverses en fonction des pays et en train d’évoluer. Certains pays ne recommandent plus le dépistage systématique, comme la Suisse.

En cas d’image très anormale, on propose une biopsie de la lésion pour voir s’il s’agit d’un cancer ou non.

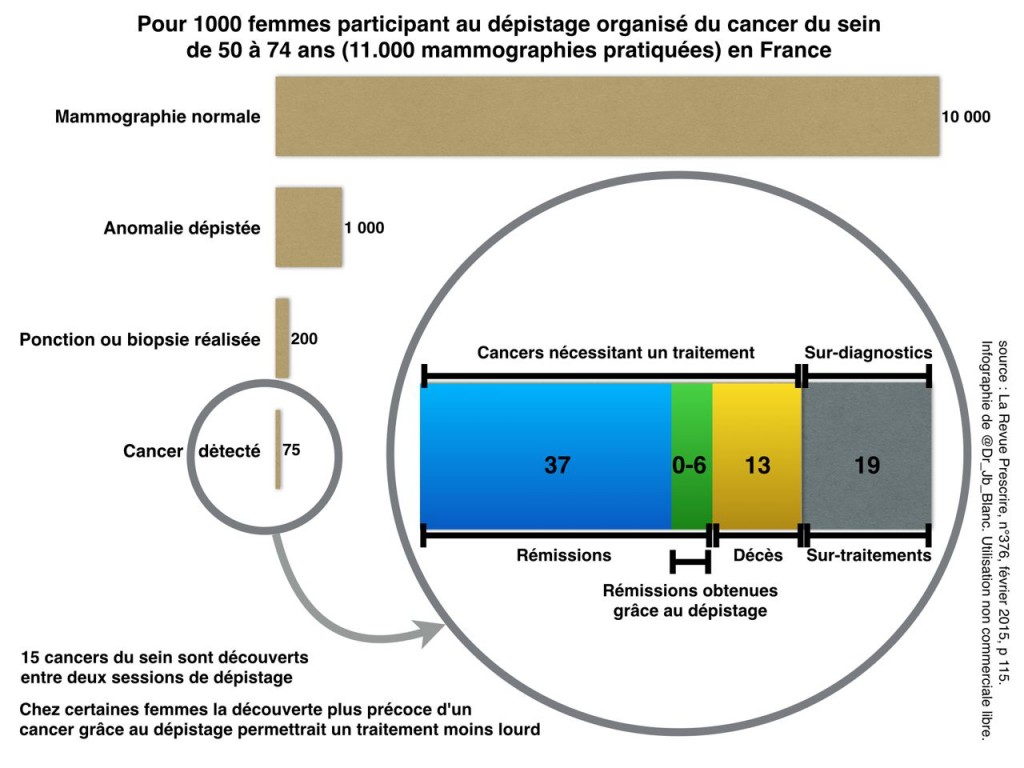

Le dépistage trouve beaucoup de cancers peu avancés, (les carcinomes canalaires in situ (CCIS)), dont l’évolution est très lente, et qui peuvent même eux-aussi régresser spontanément, donc pour lesquels les risques de surdiagnostic et de surtraitement sont a priori élevés.

Les études récentes sont sans appel sur l’impact du dépistage : diminution faible ou nulle à la fois de la mortalité spécifique et de la mortalité globale, taux important de faux positifs (10 %), et effets indésirables importants (cancers radio-induits par le dépistage radiologique lui-même, cancers induits par la radiothérapie, surtraitement conduisant à des mastectomies inutiles, effets secondaires des chimiothérapies…).

Par exemple, l’étude canadienne Miller et al. 2014 a suivi pendant 25 ans 89000 femmes, dont la moitié a effectué des mammographies annuelles ; la mammographie annuelle n’a pas réduit la mortalité spécifique, et a causé 22 % de surdiagnostics.

Plusieurs études (Bleyer et al. 2012, Zahl et al. 2004) évaluent le taux de surdiagnostics à environ 30 %.

Une étude très récente et exhaustive, comparant les pratiques en divers endroits des USA (Harding et al. 2015), sur 16 millions de femmes de 40 ans ou plus, trouve que les programmes de mammographie systématique découvrent principalement de petites tumeurs, et n’ont aucun impact sur la mortalité globale ni même spécifique ; l’étude conclut à la présence massive de surdiagnostic.

Qu’en est-il des études plus anciennes qui trouvaient un bénéfice (modéré cependant) à la mammographie ? Elles n’appliquaient pas toutes une méthodologie rigoureuse d’essai clinique aléatoire, mais surtout elles ont été conduites alors que l’arsenal thérapeutique était moins performant. Les traitements devenant plus efficaces, les bénéfices du dépistage ont diminué, alors que les effets négatifs n’ont pas changé. En outre, les femmes étaient peut-être moins attentives aux premiers signes cliniques qu’actuellement.

Il est intéressant de comparer ces résultats avec les recherches de tumeurs lors d’autopsies de femmes décédées accidentellement, qui montrent la prévalence très élevée de «cancers» chez des femmes, y compris jeunes, sans symptômes.

L’analyse la plus élaborée de ce type est Nielsen et al. 1987, qui a cherché des tumeurs chez 110 femmes de 20 à 54 ans, décédées accidentellement.

20 % des femmes présentaient des tumeurs cancéreuses (avec beaucoup de CCIS). La proportion montait à 40 % dans la tranche d’âge 40-49 ans. Ces tumeurs de petite taille régressent très probablement d’elles-mêmes puisqu’on trouve moins de cancers dans les tranches d’âge supérieures ! Un dépistage radiographique plus sensible et démarrant à 40 ans (ou pire, 30, comme des gens probablement bienveillants mais très mal informés le conseillaient ces jours-ci dans la presse) pourrait donc produire des taux de surdiagnostic énormes (plus de faux positifs, plus de cancers non évolutifs).

Avancer le dépistage à 40 ans augmente les faux positifs et le surtraitement, sans impact sur la mortalité. En outre, un faux positif infirmé par biopsie produit des effets psychologiques durables (Brodersen et al., 2013) : l’annonce de la possibilité d’un cancer a presque les mêmes conséquences psychologiques qu’un cancer confirmé.

En résumé, pour 1000 femmes subissant un dépistage systématique tous les 2 ans à partir de 50 ans, 200 subiront des examens supplémentaires (biopsies), 19 subiront un surtraitement, pour 0 à 6 vies sauvées, probablement compensées par un décès iatrogène chez les femmes surtraitées (c’est la seule explication aux études trouvant une baisse de la mortalité spécifique mais pas de la mortalité globale).

Plus de détails peuvent être trouvés dans un rapport très complet du Swiss Medical Bord (“dépistage systématique par mammographie”, 15 décembre 2013).

Le dépistage systématique par mammographie est donc non seulement inutile mais probablement nuisible, et ce d’autant plus qu’il est pratiqué chez des femmes jeunes.

3/Le cancer colorectal

Un dépistage systématique est proposé tous les deux ans par la recherche de sang dans les selles (hemoccult) pour les patients entre 50 et 74 ans. En cas de résultat positif, une coloscopie est proposée.

Cependant, ce sont surtout des tumeurs avancées qui provoquent des saignements. Et effectivement, le test de recherche de sang est caractérisé par une faible sensibilité (inférieure à 50%) et une très faible valeur prédictive (inférieure à 10%), voir par exemple Bleiberg 2002 qui dénonçait à l’époque pour ces raisons l’usage de ce test. Cela signifie que seule une coloscopie de vérification sur dix confirme la présence d’un cancer, et la moitié des cancers ne sont pas détectés au dépistage.

Une méta-analyse portant sur 245 000 patients (Moayyedi et al. 2006) a observé une petite diminution de la mortalité spécifique due au cancer colorectal après dépistage, mais une augmentation de la mortalité pour d’autres causes, et aucun impact sur la mortalité globale.

Une étude plus récente, un suivi sur 30 ans de 45000 patients (Shaukat et al. 2013, étude Minesotta), observe une diminution marginale de la mortalité spécifique (surtout en cas de test annuel plutôt que tous les deux ans, et principalement chez les hommes de 60 à 69 ans ; l’effet est nul ou marginal chez les femmes), et toujours aucun impact mesurable sur la mortalité totale.

Aucune étude publiée à ce jour n’a montré un impact positif du dépistage systématique sur la mortalité globale.

Il a été suggéré (Lang et al. 1994) qu’une part importante de la réduction observée de mortalité spécifique soit due en fait à une sélection aléatoire pour une coloscopie, qui elle a une forte sensibilité et une forte spécificité. En effet, compte tenu du fort taux de faux positifs, dans les essais cliniques avec test annuel, au moins 40% des patients subissent une coloscopie à un moment.

C’est à dire, pour simplifier, que si on choisissait au hasard 100 personnes dans la rue et qu’on leur faisait passer une coloscopie, on arriverait à un résultat probablement assez proche de celui de l’hemoccult.

L’utilisation systématique de coloscopies de dépistage n’est cependant pas viable à grande échelle, à la fois en termes de coût, et d’effets secondaires (anesthésie générale, risque de perforation ~1‰, d’hémorragie ~1‰…). Trois millions de colos, mine de rien ça fait 30 morts à cause de l’anesthésie générale, 1500 perforations, 1500 hémorragies…

Nb : nous n’avons parlé jusqu’à présent que du test hemoccult, alors qu’un nouveau test (immunologique) est maintenant proposé, qui suit à peu près le même format : recherche de sang dans les selles (un peu différemment) tous les deux ans et coloscopie proposée si positif.

Il n’y a que pour le test hemoccult que des études longues sont disponibles pour le moment. Cependant, les quelques études disponibles sur le nouveau test permettent de le comparer à l’ancien. Il n’est sensible qu’au sang humain : il permet d’éviter les faux positifs dus au steak tartare de la veille. Sa sensibilité est ajustable, et il est de manière standard pratiqué de façon à avoir deux fois plus de positifs que l’hemoccult, donc environ 5% de tests positifs au lieu de 2,5 % (ce taux est donc un choix de la part des promoteurs du test). Cela présente l’inconvénient de faire pratiquer deux fois plus de coloscopies, et donc d’engorger un peu les services concernés, et d’augmenter en proportion les effets indésirables. In fine, on a un peu moins de deux fois plus de diagnostics confirmés de cancer, avec des stades similaires : le test est donc plus sensible (par choix) mais moins spécifique (du fait ce choix de sensibilité). Un petit calcul montre qu’on peut s’attendre à un effet sur la mortalité globale sans doute moins bon qu’avec l’hemoccult, puisqu’on a plus augmenté les effets indésirables (y compris la mortalité pour autres causes) qu’on a diminué la mortalité spécifique…

Le dépistage du cancer colorectal semble donc au mieux inutile, et potentiellement nuisible compte tenu du fort taux de coloscopies induit.

4/Le cancer du col de l’utérus

Il est d’évolution en général assez lente. Il est causé par une infection virale préalable (virus HPV), et il est dépisté par le « frottis » qui consiste en un prélèvement de cellules (grosso modo on vous met un coton tige au fond du vagin pour récupérer quelques cellules sur votre col de l’utérus) et analyse cytologique, tous les 2 à 3 ans en France (3 à 5 ans dans d’autres pays) à partir de 25 ans, chez les femmes qui ont déjà eu des rapports sexuels.

(Oui oui, c’est tous les deux à trois ans. Je sais bien que plein de médecins vous disent de le faire tous les ans, mais c’est pas les recommandations. Tous les 2/3 ans c’est suffisant et même mieux, on risque moins de vous emmerder pour rien. Refusez de le faire tous les ans.)

(Et oui oui, c’est bien à partir de 25 ans. Vous laissez pas emmerder non plus si vous en avez 18.)

Il est à noter que le dépistage est beaucoup plus direct que dans tous les cas précédents, en raison de l’accessibilité du lieu de la tumeur qui permet aisément un prélèvement de surface. Un dépistage positif donne lieu à une colposcopie et à l’analyse histologique d’une biopsie.

La question du surdiagnostic et du surtraitement a été posée (par exemple Raffle et al. 2003), mais la plupart des études publiées montrent qu’un dépistage tous les 3 à 5 ans suivi d’un traitement permet environ 10 fois moins de cancers invasifs. Les effets secondaires sont réels (biopsies inutiles, impact psychologique des faux positifs), mais le dépistage a globalement un bilan positif.

On peut objecter qu’il n’existe pas d’étude de type essais cliniques randomisés, les plus fiables, comme pour les autres dépistages. Cependant, les écarts de mortalité spécifique trouvées par les études de type « case-control », plus simples mais moins fiables, sont beaucoup plus importants. En outre, les comparaisons entre les pays nordiques (Danemark, Finlande, Islande, Norvège et Suède) dans lesquels la mise en place du dépistage a été différente, mais les autres effets — hygiène, traitements — sont similaires permet de relier de manière fiable la diminution observée de mortalité et la mise en place du dépistage (Läära et al. 1987, Sigurdsson 1999).

Des dépistages trop fréquents (plus que tous les 3-5 ans) ou commençant trop jeunes (avant 25 ans) n’apportent rien, sinon plus de faux positifs (fréquents chez les femmes jeunes) (par ex. Adab et al 2004 et Kulasingam et al. 2011).

Au final, à l’heure actuelle, on est à peu près sûr que le dépistage systématique par frottis sauve des vies.

Références : on en parle ailleurs…

D’autres médecins ont écrit sur le sujet. Ils sont nombreux, et je ne pourrai pas les citer tous, mais par exemple :

— @Dr_JB_Blanc, à qui j’ai piqué l’image plus haut, avec en particulier un billet sur la prise de décision du dépistage et la déconstruction du discours des campagnes de dépistage.

— @ docdu16 , qui a publié de très nombreux billets sur le cancer du sein, un billet récent sur le dépistage, et ce depuis 2011 (et aussi là) et 2012.

– Dominique Dupagne, bien sûr, qui râle contre les PSA depuis au moins 2008, et qui a publié de nombreux articles sur la question des dépistages, genre ici, ici où il parle du chouette livre de Rachel Campergue, et beaucoup d’autres, utilisez le moteur de recherche…

– Sur Voix médicales, d’autres articles sur le cancer du sein : ici ou là ou ailleurs.

Plein de données bibliographiques et d’explications autour du dépistage du cancer du sein : http://cancer-rose.fr/

Pour ceux qui veulent creuser un peu l’histoire merveilleuse des probabilités conditionnelles : par ici.

Dans la bouche d’un patient : par là.

Si vous préférez le papier, vous pouvez lire ça ou relire ça.

(Oui les liens amazon c’est caca. Allez chez votre libraire plutôt.)

Références : articles

Prostate

Andriole et al. (2012). “Prostate cancer screening in the randomized prostate, lung, colorectal, and ovarian cancer screening trial: Mortality results after 13 years of follow-up”, Journal of the National Cancer Institute 104, 125-132.

Delpierre et al. 2013, “Life expectancy estimates as a key factor in over-treatment: The case of prostate cancer”, Cancer Epidemiology 37, 462–468.

Gulati et al. 2014, “Individualized Estimates of Overdiagnosis in Screen-Detected Prostate Cancer”, JNCI J Natl Cancer Inst 106, djt367.

Loeb et al. 2014, “Overdiagnosis and Overtreatment of Prostate Cancer”, European Urology 65, 1046–1055.

Sakr et al. 1994, “High grade prostatic intraepithelial neoplasia (HGPIN) and prostatic adenocarcinoma between the ages of 20-69: an autopsy study of 249 cases”, In Vivo 8, 439–43.

Sandhu et al. 2012, “Overdiagnosis of Prostate Cancer”, Natl Cancer Inst Monogr 45, 146–151

Schroder et al. 2012, “Prostate-cancer mortality at 11 years of follow-up”, N Engl J Med 366, 981-90.

Sein

Bleyer et al. 2012, “Effect of Three Decades of Screening Mammography on Breast-Cancer Incidence”, N Engl J Med 2012;367:1998-2005.

Brodersen et al 2013, “Long-term psychosocial consequences of false-positive dépistage mammography”, Ann Fam Med 11, 106-15.

Harding et al. 2015, “Breast Cancer Screening, Incidence, and Mortality Across US Counties”, JAMA Intern Med. 175, 1483-1489

Miller et al. 2014, “Twenty five year follow-up for breast cancer incidence and mortality of the Canadian National Breast Screening Study: randomised screening trial”, BMJ 348, g366

Nielsen et al. 187, “Breast cancer and atypia amoung yong and middle-aged women: A study of 110 medicolegal autopsies”, Br. J. Cancer 56, 814-816.

Welch et al. 1997, “Using Autopsy Series To Estimate the Disease ‘Reservoir’ for Ductal Carcinoma in Situ of the Breast: How Much More Breast Cancer Can We Find?”, AIM 127, 1023.

Zahl et al. 2004, “Incidence of breast cancer in Norway and Sweden during introduction of nationwide screening: prospective cohort study”, BMJ 328, 921.

Colon

Moayyedi et al. 2006, “Does fecal occult blood testing really reduce mortality? A reanalysis of systematic review data”, Am J Gastroenterol 101, 380-4.

Shaukat et al 2013, “Long-Term Mortality after Screening for Colorectal Cancer”, N Engl J Med 369, 1106-14.

Bleiberg 2002, “Hemoccult should no longer be used for the screening of colorectal cancer”, Ann Oncol 13, 44-46.

Lang et al 1994, “Fecal occult blood screening for colorectal cancer. Is mortality reduced by chance selection for screening colonoscopy”, JAMA 271, 1011–1013

Col de l’utérus

Raffle et al. 2003, “Outcomes Of Screening To Prevent Cancer: Analysis Of Cumulative Incidence Of Cervical Abnormality And Modelling Of Cases And Deaths Prevented”, BMJ 326, 901-904.

Adab et al. 2004, “Effectiveness and Efficiency of Opportunistic Cervical Cancer Screening: Comparison with Organized Screening”, Medical Care 42, 600-609.

Kulasingam et al. 2011, “Screening for Cervical Cancer: A Decision Analysis for the US Preventive Services Task Force”, AHRQ No. 11-05157-EF-1. Rockville, MD: Agency for Healthcare Research and Quality.

Sigurdsson et al. 1999, “The Icelandic and Nordic cervical screening programs: Trends in incidence and mortality rates through 1995”, Acta Obstet Gynecol Scand 78, 478–485.

Läära et al 1987, “Trends in mortality from cervical cancer in the nordic countries: association with organised screening programmes”, The Lancet 1987:1, 1247.